Présentation de la virtualisation :

Tout d’abord une petite définition de la virtualisation s’impose. La virtualisation consiste à utiliser un ou plusieurs systèmes d’exploitation sur une seule et même machine physique. Ce procédé permet de mutualiser les systèmes d’exploitation (dans la limite des performances des machines physiques) au lieu de ne pouvoir installer qu’un seul par machine.

Dans une architecture classique nous allons retrouver deux couches :

• La couche matérielle (ensemble des périphériques matériels du serveur physique)

• La couche logicielle (système d’exploitation et applications).

Pour la virtualisation on vient ajouter à la couche logicielle (système d’exploitation) une autre couche appelée Hyperviseur. Cette couche permet de répondre aux différentes contraintes provoquées par les différents constructeurs de périphériques informatiques de part les différences présentes avec les pilotes.

Un Hyperviseur va donc être déployé entre la couche matérielle et les différents conteneurs (également appelés machine virtuelle qui contient toutes les caractéristiques fonctionnelles d’un système d’exploitation) pour permettre une relation optimal entre les périphériques virtuels et les périphériques physiques.

Concrètement une fois l’hyperviseur installé sur le serveur physique, les machines virtuelles déployées sur ce serveur fonctionneront normalement et ce sans avoir besoin du pilote constructeur. Par exemple un changement de carte réseau sur ce serveur sera transparent pour les machines virtuelles.

De ce fait voici en document le principe de fonctionnement de l’architecture virtuelle une fois l’Hyperviseur mis en place :

• En premier lieu nous retrouvons l’architecture dite matérielle, qui regroupe les périphériques matériel présent dans un serveur tel que le processeur, la mémoire, les cartes réseaux et les disques durs.

• Puis vient la couche logicielle maintenant composée de l’Hyperviseur qui remplace le système d’exploitation de l’architecture classique

• Enfin la dernière couche qui regroupe les différents conteneurs avec les systèmes d’exploitation et les applications des machines virtuelles.

Avantages et inconvénients :

Aujourd’hui les entreprises utilisent de plus en plus cette technologie et ce n’est pas anodin, en effet c’est un vrai choix judicieux de part ces nombreux avantages :

• L’un des principaux avantages, et non pas sans conséquence, est celui de la réduction des coûts liés aux achats des serveurs. En effet la virtualisation permet pour un serveur physique d’avoir une multitude de serveurs virtuels et ce fonctionnant tous indépendamment des autres. Le seul partage étant les ressources physiques disponibles sur le serveur physique.

• L’économie d’énergie par l’intermédiaire de la réduction des matériels de refroidissement permet une réduction de prés de 80% sur la facture énergétique.

• Cette mutualisation permet une utilisation optimale des ressources pour toutes les machines virtuelles grâce au procédé de répartition des charges des machines virtuelles sur les machines physiques en fonction des charges respectives.

• La facilité d’administration (installation, déploiement et migration) est aussi présente dans les avantages car cette administration est centralisée.

• Continuité de service, en cas de dysfonctionnement physique ou logiciel de l’hôte, grâce à la possibilité de migration de machine virtuelle en fonctionnement.

• Plan de reprise d’activité avec la possibilité de restaurer les machines virtuelles après une destruction de serveurs physique. Cela étant possible si les sauvegardes ou les clichés instantanés des machines virtuelles ont été effectuées régulièrement.

• La possibilité de dimensionnement de chaque machine virtuelle, cet avantage est à prendre en compte impérativement sous peine de voir cet avantage se transformer en inconvénient.

La virtualisation possède tout de même quelques inconvénients :

• Le premier est en rapport avec le dimensionnement vu précédemment, en effet si celui-ci n’est pas pris en compte, par exemple lors d’un fort pic d’intensité la machine virtuelle ou le serveur virtualisé peut très vite manquer de ressource et par conséquent les performances en seront impactées. C’est pour cela que ces aspects doivent être calculés au préalable pour obtenir un rendement optimal et ce dans n’importe quelles situations.

• Cette une technologie qui demande beaucoup de savoir faire, de plus celle-ci est en pleine évolution il est d’autant plus difficile de tout savoir maîtriser mise à part un professionnel. De plus il possible de configurer des LAN, SAN et des switch par l’intermédiaire de la virtualisation mais cette administration est très complexe.

• Si une machine physique tombe en panne, c’est l’intégrité des machines virtuelles qui est affectée, mais cet inconvénient est invisible si l’entreprise choisi de mettre en place un site miroir.

• La virtualisation de base de données, celle-ci est un inconvénient car elle tout simplement pas conseillée, en effet la taille de celle-ci est en constante évolution et il est nécessaire d’utiliser toutes les ressources d’un serveur physique.

Solutions présentes sur le marché actuel :

Aujourd’hui ce marché, est dominé principalement par VMware. VMWare, société américaine fondée en 1998 et devenue en 2004 une filiale d’EMC Corporation, propose plusieurs produits propriétaires liés à la virtualisation d’architectures

Juste après nous retrouvons Microsoft arrivé récemment avec son Hyperviseur qui se nomme « Hyper-V » qui se trouve sous forme d’un rôle sur Windows Server 2008 et Windows Server 2012. Malgré une récente arrivé comparé à VMWare, Microsoft se positionne en tant que leader sur les serveurs x86.

Nous retrouvons ensuite Citrix qui a racheté la société XenSource en 2007, lui permettant ainsi d’entrer sur ce marché de la virtualisation. Cependant aujourd’hui Citrix ne se positionne plus vraiment comme un concurrent de Microsoft et VMware sur le marché de la virtualisation de serveur, la solution open source est désormais un acteur de Niche pour la virtualisation des serveurs x86.

Toutes ces solutions ont en commun des mécanismes d’une très grande utilité et font de la virtualisation une technologie phare dans les entreprises aujourd’hui. Nous allons donc présenter brièvement ces mécanismes.

Un premier mécanisme très important pour éviter l’interruption de service est la migration à chaud de serveurs. Ce mécanisme permet de migrer une machine virtuelle présente sur un hôte vers un autre et ce sans à devoir éteindre la machine comme on le ferait sur une architecture classique. De plus lors de cette migration les pilotes nécessaires sur l’hôte de destination ne sont plus à prendre en compte puisque l’Hyperviseur se charge de tout.

Principe de migration à chaud (Source : vmware.com)

Ce mécanisme décrit ci-dessus appartient à ce que l’on appel la haute disponibilité. Un exemple concret que j’ai vu en entreprise est le mode dépannage sur la solution VMWare qui permet de migrer toutes les machines virtuelles présentes sur un autre hôte le temps de faire la maintenance sur l’hôte d’origine.

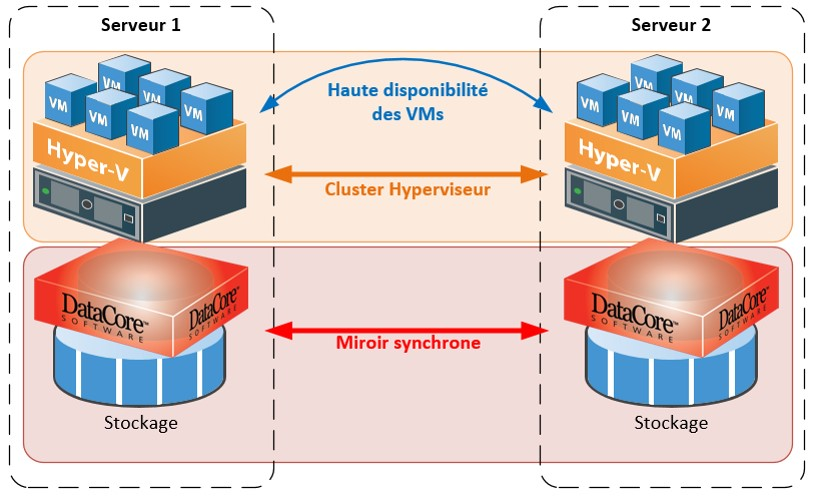

Principe de Haute disponibilité

La haute disponibilité garantit de deux façons qu’un système fonctionne à son plus haut niveau de performances : le service ou serveur donné doit être accessible (ou disponible) à tout moment ou presque, sans interruption, et présenter des performances satisfaisantes sur une période donnée.

Elle assure le bon fonctionnement, la résilience et la fiabilité des systèmes.

L’infrastructure est capable de répartir intelligemment les ressources disponibles entre les machines virtuelles, de plus lorsqu’un hôte dispose de ressources non utilisées, l’infrastructure est capable de repositionner les machines virtuelles et de libérer les hôtes de leurs machines virtuelles pour les placer en hibernation jusqu’à une nouvelle monté en charge nécessitant des ressources supplémentaires.

Perspective d’évolution :

Une des nouveautés majeures annoncées à la conférence de VMWorld 2015 est la possibilité de migrer des VM entre clouds privés et clouds publics.

Clairement le cloud et une perspective d’évolution de la virtualisation, le cloud repose sur les fondements même de la virtualisation c’est-à-dire une délocalisation du hardware.

L’avenir du datacenter tend vers une virtualisation totale et ainsi vers le cloud computing pour les entreprises avec une évolution vers une architecture de type IaaS (infrastructure matérielle, louée à la demande : stockage, machines virtuelles, OS, etc. L’entreprise peut, dans ce cas, disposer sur demande d’une capacité de traitement pour n’importe quel type d’application).

Conclusion :

La virtualisation est une technologie puissante et une permet souvent la réussite du développement d’une entreprise en minimisant les coûts et en proposant une centralisation des services mais elle nécessite aussi un personnel très qualifié pour la mettre en place et pour assurer sa viabilité. Une étude poussée doit avoir lieu au préalable afin déterminer si le choix de la virtualisation est judicieux.